Sans SEO, un site web reste invisible. Quiconque souhaite être trouvé sur Internet doit comprendre comment les moteurs de recherche fonctionnent et quels facteurs influencent le classement. Des premières astuces des années 90 aux algorithmes modernes basés sur l’IA – une introduction compacte aux bases et aux développements de l’optimisation pour les moteurs de recherche jusqu’à aujourd’hui.

- Principes fondamentaux de l'optimisation des moteurs de recherche (SEO)

- Pertinence pour les sites web et les entreprises

- Démarcation par rapport aux disciplines apparentées du marketing en ligne

- Objectifs et avantages du SEO

- Parts de marché des moteurs de recherche

- Moteurs de recherche IA : Opportunités et risques

- Moteurs de recherche – comment fonctionnent-ils réellement ?

- Le développement du SEO

- SEO moderne : RankBrain, SEO mobile et algorithmes basés sur l'IA

- Que dit Google à propos de l'optimisation des moteurs de recherche ?

- Comment SISTRIX aide avec le SEO

- Défis et développements futurs

- Séminaires SEO SISTRIX pour débutants

Principes fondamentaux de l’optimisation des moteurs de recherche (SEO)

Le SEO englobe toutes les mesures visant à améliorer la visibilité organique d’un site web. L’objectif est d’apparaître le plus haut possible pour les requêtes de recherche pertinentes et de générer un trafic qualifié. Les moteurs de recherche évaluent les sites web en fonction de critères techniques, de contenu et structurels. Des optimisations ciblées facilitent l’indexation et augmentent la pertinence.

Le SEO se divise en trois domaines :

- On-Page-SEO : Optimisation du contenu, des liens internes et des métadonnées directement sur le site web.

- Off-Page-SEO : Relations presse, RP et liens provenant de sites externes pertinents qui renforcent la confiance et l’autorité d’un site web.

- SEO technique : Amélioration des temps de chargement, de la convivialité mobile et de l’explorabilité par les robots des moteurs de recherche.

Pertinence pour les sites web et les entreprises

Un positionnement sur la première page des résultats de recherche Google augmente non seulement le nombre de visiteurs, mais améliore également la qualité du trafic, car les utilisateurs recherchent spécifiquement des informations ou des produits. Pour les entreprises, cela signifie une visibilité accrue, plus de clients potentiels et une augmentation à long terme de la notoriété de la marque. Un autre avantage est la durabilité : alors que la publicité payante entraîne des coûts continus, une stratégie SEO réussie peut produire des résultats à long terme sans avoir à payer pour des clics individuels.

L’importance d’un classement élevé est soulignée par une analyse complète de SISTRIX, qui a examiné 80 millions de mots-clés et des milliards de résultats de recherche. L’étude a révélé que le taux de clics (CTR) moyen sur la première position de Google est de 28,5 %. En deuxième position, il tombe à 15,7 %, et en troisième position à 11,0 %. Le dixième résultat n’est cliqué en moyenne que par 2,5 % des chercheurs. Ces chiffres illustrent à quel point il est crucial d’atteindre un classement parmi les 10 premiers résultats de recherche grâce à une optimisation ciblée, afin d’être perçu par les clients potentiels et d’obtenir des clics de Google.

Démarcation par rapport aux disciplines apparentées du marketing en ligne

Le SEO est étroitement lié à d’autres stratégies, mais diffère dans son approche :

- SEO vs. SEA : Alors que le SEO mise sur les classements organiques, la publicité sur les moteurs de recherche (SEA) utilise des annonces payantes pour une visibilité immédiate dans les moteurs de recherche.

- SEO et Content-Marketing : Un contenu de haute qualité améliore la pertinence et favorise de meilleurs classements.

- SEO et Médias Sociaux : Les médias sociaux peuvent augmenter la portée et le trafic, mais ils n’influencent pas directement le classement dans les moteurs de recherche.

Objectifs et avantages du SEO

Pour les entreprises, le SEO est un moyen rentable d’atteindre durablement les clients sans avoir à payer pour chaque clic. Un site web bien optimisé peut générer du trafic organique pendant des années sans frais publicitaires courants. De plus, les résultats organiques sont souvent perçus comme plus fiables que les annonces payantes.

Dans la Google Search Console, la portée (clics) obtenue via Google peut être prouvée.

Le SEO améliore non seulement les classements et la portée, mais aussi l’expérience utilisateur : des temps de chargement rapides, une structure de page claire et un contenu de haute qualité aident aussi bien les moteurs de recherche que les visiteurs.

Parts de marché des moteurs de recherche

Google domine le marché des moteurs de recherche avec une large avance. La part de marché de Google dépasse 90 % dans de nombreux pays. D’autres moteurs de recherche tels que Bing, DuckDuckGo ou Yahoo jouent un rôle secondaire. Dans certaines régions, il existe des alternatives qui desservent des marchés spécifiques, comme Baidu en Chine ou Yandex en Russie. Néanmoins, la plupart des stratégies de référencement sont basées sur les algorithmes de Google, car ils ont la plus grande influence sur le trafic organique.

Moteurs de recherche IA : Opportunités et risques

Avec le développement de l’intelligence artificielle (IA), les moteurs de recherche évoluent également. Les systèmes de recherche basés sur l’IA, tels que ChatGPT Search ou Perplexity AI, présentent des approches alternatives pour la recherche d’informations. Contrairement aux moteurs de recherche classiques, ils ne fournissent pas une liste de résultats, mais génèrent des réponses directes aux requêtes.

Cette évolution apporte à la fois de nouvelles opportunités et des défis.

- Réponses rapides et concises : les moteurs de recherche IA peuvent résumer des contenus complexes et répondre directement aux questions.

- Sélection manquante : Alors que Google offre une multitude de sources, les moteurs de recherche basés sur l’IA ne proposent souvent qu’une seule réponse. Il manque ainsi la possibilité de comparer différentes perspectives.

- Réponses apparemment correctes : Les modèles d’IA sont basés sur des données d’entraînement qui ne sont pas toujours à jour ou fiables. Les informations erronées ou obsolètes ne peuvent pas toujours être reconnues.

- Sources inconnues : les utilisateurs ne savent pas exactement sur quelles données les réponses sont basées. Alors que les moteurs de recherche classiques fournissent une liste traçable de sites Web, il n’est souvent pas clair d’où proviennent les informations dans les réponses générées par l’IA.

- Manque d’orientation : les moteurs de recherche basés sur l’IA n’offrent pas de navigation directe vers des contenus supplémentaires, comme le font les moteurs de recherche classiques avec des résultats organiques.

Pour le référencement, cette évolution signifie que le contenu doit être optimisé non seulement pour les moteurs de recherche traditionnels, mais aussi pour les systèmes basés sur l’IA. Parallèlement, la recherche classique reste pertinente, car elle offre aux utilisateurs une sélection transparente de résultats et une meilleure comparabilité des sources.

Moteurs de recherche – comment fonctionnent-ils réellement ?

Les moteurs de recherche comme Google explorent Internet avec des robots d’exploration qui suivent les liens, capturent les pages web et indexent leur contenu. Cet index sert de base aux résultats de recherche. Les pages nouvelles ou mises à jour sont régulièrement enregistrées afin que les utilisateurs trouvent toujours des informations pertinentes. Sans indexation, un site web ne serait pas visible dans les résultats de recherche.

Pour qu’une page apparaisse pour une requête de recherche, l’algorithme évalue différents facteurs. Ceux-ci incluent la pertinence du contenu, la structure technique de la page et des signaux externes tels que les liens. L’objectif est de fournir à l’utilisateur les meilleurs résultats. Le fonctionnement exact reste secret, mais les pratiques de référencement éprouvées aident à obtenir un classement élevé.

Les moteurs de recherche tiennent compte non seulement du contenu, mais aussi de la convivialité. Des aspects tels que les temps de chargement, l’optimisation mobile et une structure claire influencent la durée du séjour des visiteurs sur une page et la rapidité avec laquelle ils trouvent les informations recherchées. Ces signaux d’utilisateur contribuent à l’évaluation de la pertinence et peuvent influencer positivement le classement.

Google met continuellement à jour son algorithme. Plusieurs fois par an, des Core Updates entraînent des changements dans les résultats de recherche. Les critères d’évaluation existants sont alors ajustés ou de nouveaux facteurs sont pris en compte, ce qui peut entraîner des déplacements de classement. Les stratégies SEO réussies doivent rester flexibles et s’adapter aux développements actuels.

Le développement du SEO

Dans les années 1990, les premiers moteurs de recherche comme AltaVista, Yahoo et plus tard Google sont apparus. Au début, les algorithmes étaient simples et évaluaient les pages principalement en fonction de la fréquence de certains termes. Les entreprises en ont profité en plaçant excessivement des mots-clés (« bourrage de mots-clés ») ou en insérant des textes cachés. Des liens massifs et de mauvaise qualité ont également été utilisés pour améliorer artificiellement le classement.

Étant donné que ces méthodes détérioraient de plus en plus les résultats de recherche, Google a commencé à effectuer des mises à jour régulières de son algorithme dans les années 2000. La mise à jour Panda (2011) a réduit la visibilité des contenus de mauvaise qualité, tandis que la mise à jour Penguin (2012) a pénalisé les structures de liens non naturelles. Avec la mise à jour Hummingbird (2013), l’importance sémantique d’une requête de recherche a été davantage mise en avant, de sorte que les pages n’étaient plus évaluées uniquement par des mots-clés individuels, mais par leur contexte global. Ces ajustements ont contraint les entreprises à se concentrer davantage sur des contenus de haute qualité et des structures de liens naturelles.

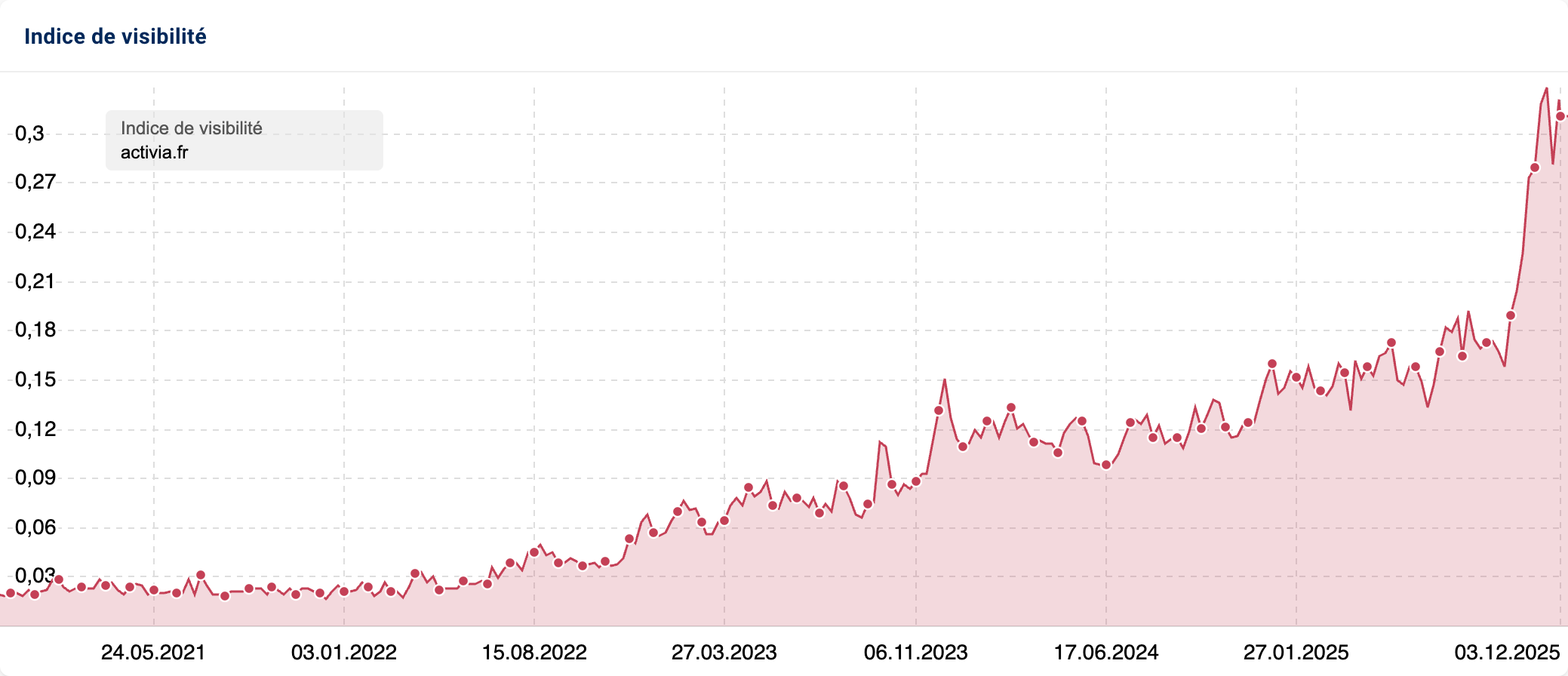

Avec la complexité croissante du SEO, le besoin d’outils d’analyse professionnels a augmenté. SISTRIX a été fondé en 2008 et est rapidement devenu l’un des principaux outils de mesure de la visibilité organique. L’indice de visibilité offre un moyen transparent de suivre les changements de classement et d’effectuer des optimisations ciblées.

SEO moderne : RankBrain, SEO mobile et algorithmes basés sur l’IA

Depuis 2015, l’intelligence artificielle et l’apprentissage automatique jouent un rôle de plus en plus important. Avec RankBrain, Google a introduit un système qui comprend mieux les requêtes de recherche et fournit des résultats contextuels. Parallèlement, l’optimisation mobile a gagné en importance, car de plus en plus d’utilisateurs recherchent via des smartphones. L’index mobile-first garantit que la version mobile d’un site Web constitue la base principale du classement. Outre l’optimisation technique, les contenus de haute qualité qui s’orientent vers l’intention de recherche des utilisateurs sont aujourd’hui particulièrement déterminants.

Les systèmes d’IA tels que le MUM (Multitask Unified Model) de Google analysent désormais le contenu en fonction du contexte et comprennent les requêtes de recherche complexes avec plus de précision que les algorithmes précédents. Dans le même temps, les moteurs de recherche basés sur l’IA, qui fournissent des réponses directement au lieu de simplement présenter des liens, gagnent en importance. Ces développements nécessitent de nouvelles approches d’optimisation, car les facteurs de classement classiques pourraient perdre de leur influence.

Que dit Google à propos de l’optimisation des moteurs de recherche ?

Google établit des directives claires pour garantir des résultats de recherche de haute qualité. Ces recommandations aident les opérateurs de sites web à optimiser leur contenu afin qu’il soit pertinent aussi bien pour les utilisateurs que pour le moteur de recherche.

Un facteur central est la qualité du contenu. Les sites web doivent offrir des informations précises, utiles et bien structurées qui répondent à l’intention de recherche. Le contenu qui fournit des réponses directes et fondées aux questions des utilisateurs a de meilleures chances d’obtenir un bon classement.

La mise en œuvre technique joue également un rôle crucial. Une structure de page claire permet aux moteurs de recherche de mieux saisir et classer le contenu. Des temps de chargement rapides et une optimisation mobile améliorent non seulement l’expérience utilisateur, mais sont également des facteurs de classement.

Afin d’éviter les manipulations, Google déconseille les techniques de spam telles que le bourrage de mots-clés, le cloaking ou la création de liens non naturels. De telles méthodes peuvent entraîner une pénalité, voire une suppression de l’index. Les stratégies SEO durables, basées sur la qualité, la pertinence et l’optimisation technique, sont plus efficaces à long terme.

Outre ces facteurs, Google recommande l’utilisation de données structurées et de méta-tags optimisés. Les titres, descriptions et balises aident le moteur de recherche à mieux interpréter le contenu et à le présenter de manière attrayante dans les résultats de recherche. Google conseille également explicitement de travailler dès le début avec des consultants ou des agences SEO afin d’éviter les erreurs lors de la création d’un nouveau domaine.

Comment SISTRIX aide avec le SEO

SISTRIX permet des analyses complètes pour évaluer et optimiser spécifiquement la performance SEO d’un site web. Trois fonctions centrales aident à obtenir de meilleurs classements et à se positionner face à la concurrence.

Un élément essentiel est l’indice de visibilité. Il montre la performance d’un site web dans les résultats de recherche, rend les évolutions de classement mesurables et aide à identifier les potentiels d’optimisation. Des mises à jour régulières permettent d’analyser les changements à un stade précoce et de prendre des mesures appropriées. L’indice sert non seulement à contrôler le succès de sa propre stratégie de référencement, mais aussi à le comparer avec les concurrents.

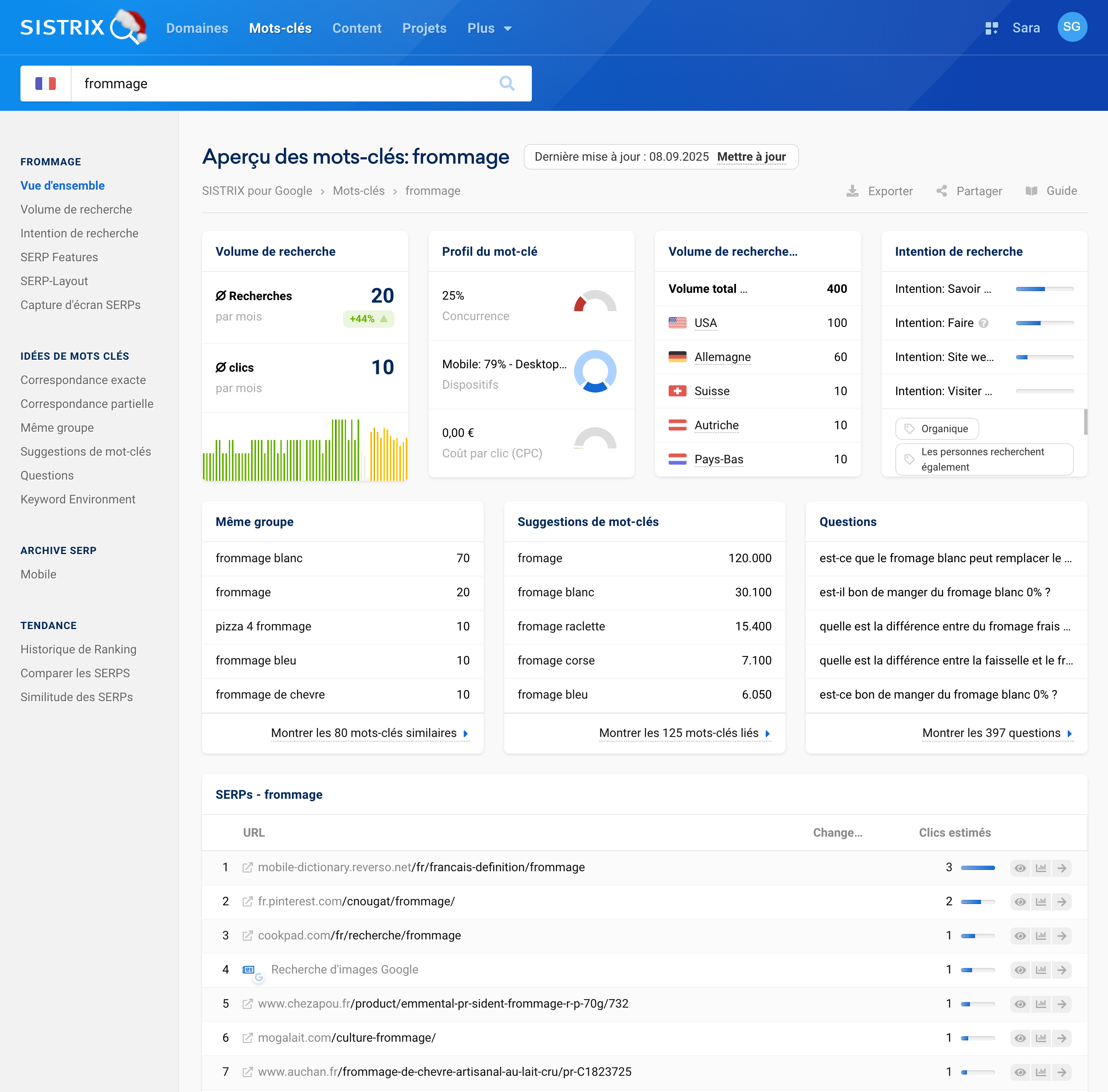

Une autre fonctionnalité clé est la découverte de mots-clés. Elle aide à identifier les termes de recherche pertinents à fort potentiel. Outre le volume de recherche, SISTRIX fournit des données sur la densité concurrentielle et le classement actuel. Il est ainsi possible d’optimiser spécifiquement les mots-clés qui génèrent plus de trafic organique.

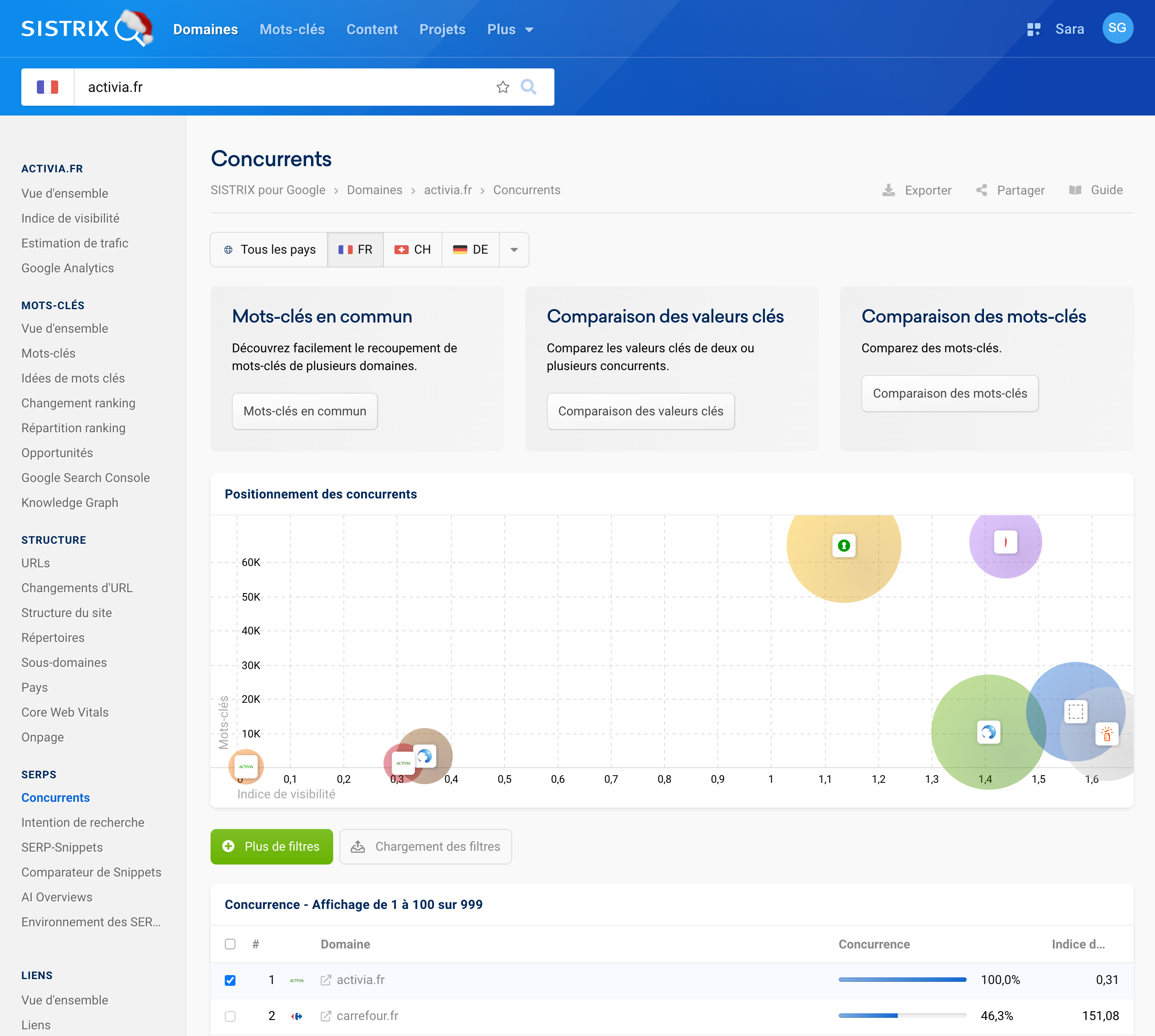

L’analyse concurrentielle révèle pour quels mots-clés d’autres acteurs du marché sont bien classés et où il existe des opportunités d’optimisation. Ces informations aident à identifier les lacunes stratégiques et à les exploiter de manière ciblée. En complément, SISTRIX offre des fonctions d’analyse technique, d’évaluation des backlinks et de mesure du succès.

Découvrez dès maintenant les diverses possibilités de SISTRIX pour optimiser spécifiquement votre site web. Testez SISTRIX gratuitement pendant 14 jours et analysez comment rendre votre site web plus visible.

Défis et développements futurs

Le SEO est en constante évolution, car les moteurs de recherche adaptent régulièrement leurs algorithmes. Outre les changements techniques, les exigences réglementaires gagnent en importance.

Un sujet important est la lutte contre le spam. Google améliore continuellement ses méthodes pour détecter et pénaliser les contenus de mauvaise qualité ou manipulateurs. Le bourrage de mots-clés, les structures de liens non naturelles et d’autres techniques obsolètes perdent de leur efficacité. Au lieu de cela, les stratégies de référencement (SEO) réussies mettent davantage l’accent sur la valeur ajoutée pour les utilisateurs.

Le rôle de l’intelligence artificielle et de l’automatisation est croissant. Le machine learning n’est pas seulement utilisé dans les algorithmes de recherche, mais aussi pour la création et l’optimisation de contenu. Les systèmes basés sur l’IA analysent les intentions de recherche, génèrent du contenu et structurent les pages web. Par conséquent, les contenus uniques, approfondis et bien documentés gagnent en importance, tandis que les textes génériques sont de plus en plus automatisés.

La protection des données et la régulation des cookies influencent également les stratégies SEO. Des directives de protection des données plus strictes telles que le RGPD et les restrictions de suivi modifient les possibilités d’analyse des utilisateurs. Sans données personnelles détaillées, l’optimisation contextuelle est davantage mise en avant, car les moteurs de recherche évaluent le contenu indépendamment des profils d’utilisateurs individuels.

Ces évolutions exigent une stratégie de référencement flexible, qui s’adapte aux nouveaux algorithmes, aux avancées technologiques et aux exigences réglementaires.

Séminaires SEO SISTRIX pour débutants

Le SEO exige non seulement des connaissances techniques, mais aussi une compréhension des stratégies d’optimisation efficaces. Pour faciliter le démarrage, SISTRIX propose des séminaires (en ligne) pratiques.

Les participants apprennent à utiliser SISTRIX spécifiquement pour les analyses, à évaluer leur visibilité, à identifier les mots-clés pertinents et à effectuer des analyses concurrentielles. De plus, des conseils pratiques sont donnés pour éviter les erreurs typiques et exploiter spécifiquement le potentiel d’optimisation.

Les séminaires sont également accessibles sans compte SISTRIX existant. Un compte d’essai gratuit permet de participer et donne un accès direct à la Toolbox.

Quiconque souhaite approfondir ses connaissances en référencement et obtenir une introduction structurée à la boîte à outils SISTRIX peut s’inscrire directement à l’un des prochains séminaires. Testez-le gratuitement dès maintenant et faites le premier pas vers une optimisation professionnelle des moteurs de recherche.

Essayez SISTRIX gratuitement

- Essai gratuit de 14 jours

- Sans engagement et sans annulation nécessaire

- Onboarding personnalisé avec nos experts