Il arrive parfois que le robot d’indexation SISTRIX ne puisse pas capturer entièrement tous le contenu d’un site Web. Dans ce tutoriel, nous allons vous présenter les causes les plus courantes ainsi que leurs contextes, vous expliquer le contexte et vous montrer les solutions à ces problèmes.

Le robot d’indexation SISTRIX

Tous les accès à la SISTRIX Toolbox sont réalisés par le robot d’indexation SISTRIX. Deux caractéristiques permettent d’identifier ce robot : tout d’abord l’agent utilisateur, qui est automatiquement transmis à chaque fois qu’un site Web est consulté. Par défaut, l’agent utilisateur est :

Mozilla/5.0 (compatible; SISTRIX Crawler; http://crawler.sistrix.net/)Ensuite, toutes les adresses IP du robot SISTRIX indiquent le nom d’hôte du domaine « sistrix.net ». Par exemple, sur l’adresse IP 136.243.92.8, notre robot renverrait l’entrée DNS inverse 136-243-92-8.crawler.sistrix.net.

Le robot SISTRIX surveille de près et en permanence la vitesse de chargement des pages visitées et ajustera la vitesse à laquelle de nouvelles pages sont demandées à cette vitesse-là. Ainsi, nous pouvons être sûrs de ne pas surcharger le serveur.

Dans les projets Onpage, vous avez aussi la capacité de contrôler l’agent utilisateur et l’intensité d’exploration du robot. Vous trouverez ces règlages dans chaque projet dans « Paramètres > Crawler Onpage » et dans « Paramètres > Paramètres expert ». Vous pourrez modifier la fréquence de crawl mais aussi le jour et l’heure, entre autres.

robots.txt

Avant d’accéder à un site Internet, notre Crawler va demander un fichier dont le nom est « robots.txt » dans le répertoire racine, ainsi que chaque nom d’hôte, du domaine. S’il trouve ce fichier, il l’analysera et observera attentivement les règles et restrictions indiquées à l’intérieur. Les règles s’appliquant uniquement à « sistrix » seront acceptées, tout comme les règles générales portant l’identifiant « * ». Si vous utilisez un fichier robots.txt, nous vous recommandons de bien en vérifier le contenu pour vous assurer que le robot SISTRIX n’a pas été accidentellement restreint.

Si vous utilisez un plan du site pour le robots.txt, notre robot y accèdera comme base d’exploration.

Cookies

Le robot SISTRIX ne va pas enregistrer les cookies lors de sa navigation sur une page. Nous vous conseillons donc de vous assurer que notre Crawler peut accéder à toutes les sections de la page sans avoir à accepter de cookies.

JavaScript

Notre robot n’utilise pas JavaScript. Veuillez vous assurer que toutes les pages sont accessibles en pages HTML statiques, afin qu’il puisse toutes les analyser.

Restrictions du côté des serveurs

Le robot SISTRIX peut être soumis à des restrictions du côté des serveurs. Dans ce cas, notre robot recevra un message d’erreur avec le code HTTP 403 (accès refusé) quand il tentera d’accéder à la page pour la première fois et n’aura accès à aucune page de ce serveur. Une telle restriction du côté du serveur peut être placée sur d’autres niveaux du système. Un bon point de départ serait de vérifier le fichier « .htaccess » du serveur web Apache. Si vous ne trouvez aucun indice dans cette section, nous vous recommandons de contacter le fournisseur ou l’hébergeur. Malheureusement, il nous est impossible de désactiver ces restrictions nous-mêmes.

Exemples de restrictions courantes

restrictions robots.txt

Si le robots.txt refuse l’accès au robot de l’Optimizer, vous recevrez un message d’erreur « robots.txt refuse les explorations ». Nous vous recommandons alors de vérifier s’il y a des restrictions générales (User-Agent: *) ou des spécifiques (User-Agent: Sistrix) dans votre fichier robot.txt. Si vous avez également modifié l’agent utilisateur dans les paramètres du robot d’exploration de votre projet, il serait préférable de les vérifier également.

Seulement quelques pages ont été explorées ou aucune ne l’a été

Il existe de nombreuses raisons pour lesquelles l’analyse de notre Crawler est limitée à un petit nombre de pages, voire même aucune page. Dans le projet Onpage, rendez-vous dans « Mode expert ». Vous trouverez alors une longue liste de tous les documents HTML explorés du domaine. Vous pouvez trouver le code en vous déplaçant un peu à droite dans le tableau. Cela devrait vous dire pourquoi toutes les pages associées à ce domaine n’ont pas été explorées.

- 200: Si le code est 200 mais qu’aucune autre page n’a été explorée, la raison est souvent l’une des suivantes :

- Liens internes manquants : Notre robot suit tous les liens internes qui ne sont pas bloqués lors de l’exploration. Veuillez vérifier que tous les liens internes de la page d’accueil sont présents et qu’aucune page cible ne bloque le robot en utilisant soit le robot.txt soit les paramètres d’exploration.

- Paramètres Geo-IP : Pour présenter le site Internet dans la langue correspondante pour chaque utilisateur, l’IP sera analysée pour trouver le pays d’origine. Tous nos scans sont effectués en Allemagne, une liste blanche doit donc exister pour notre Crawler-IP si vous souhaitez accéder à tous les contenus linguistiques disponibles derrière la barrière Geo-IP.

- 301 / 302: Si le code 301 ou 302 apparaît, nous vous conseillons de vérifier si le lien mène à un domaine différent – par exemple sistrix.at, qui mène à sistrix.de par une redirection 301. Le robot reste toujours sur le domaine (ou sur l’hôte ou le répertoire) saisi dans les paramètres du projet. Si nous créons un projet pour sistrix.at, par exemple, notre Crawler reconnaîtrait la redirection 301 et l’afficherait dans la section « Mode Expert », mais sans la suivre jusqu’à sistrix.de, car ce dernier est un domaine différent.

- 403: Si le code 403 apparaît immédiatement, ou si après quelques pages explorables (code 200) seul le code 403 apparaît, vous devriez vérifier pourquoi le serveur bloque notre Crawler et ne lui permet pas d’accéder au pages. Nous vous recommandons de lire le paragraphe « Restrictions du côté des serveurs ».

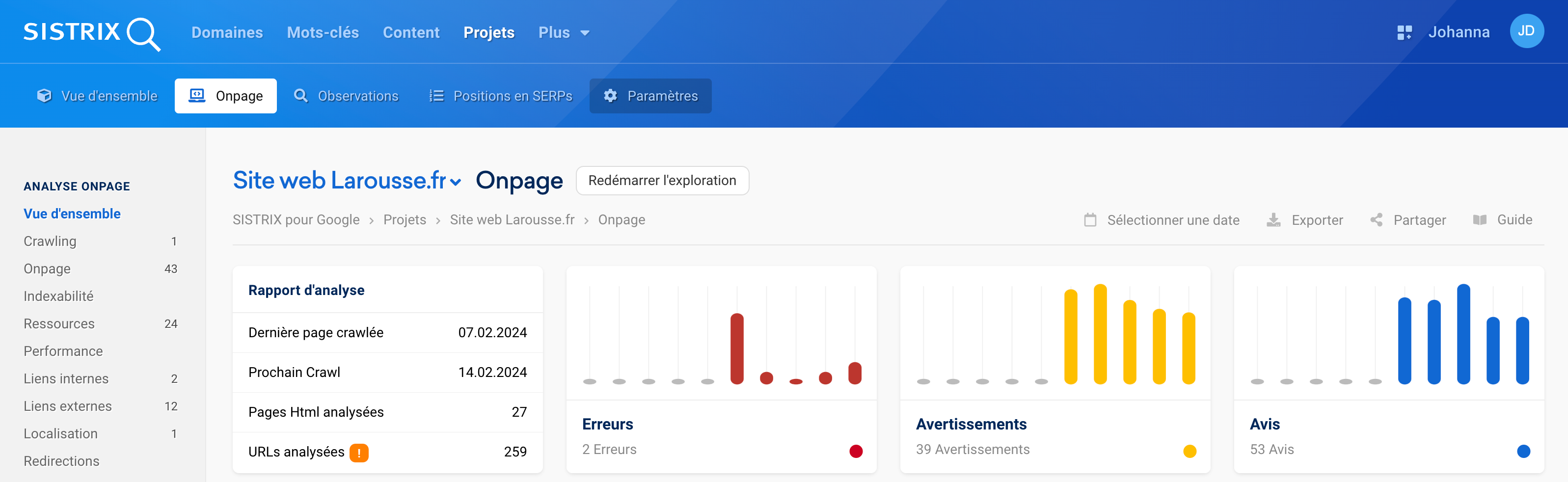

- 5xx: Si le code 500 ou 5xx apparaît dans le champ de code, cela signifie que le serveur n’a pas pu s’occuper de notre demande à cause d’une erreur de serveur. Dans ce cas-là, vous devriez patienter quelques minutes puis utiliser le bouton « Redémarrer l’exploration »1 qui apparaît en cliquant sur Onpage dans le menu horizontal bleu. Si le code 5xx continue d’apparaître, vérifiez que le serveur n’est pas surchargé et incapable d’ouvrir les pages demandées.

Pourquoi Google trouve-t-il un contenu différent de celui de SISTRIX ?

Notre robot démarre toujours par les pages de démarrage du projet, bien que davantage de pages de démarrage puissent être ajoutées dans les paramètres du robot. À partir de là, nous suivrons tous les liens internes qui ne sont pas bloqués. Sur ces pages liées, nous suivrons tous les liens internes jusqu’à ce que nous trouvions tous ceux que nous n’avons pas encore demandés.

Ce qui peut arriver, par exemple, c’est que les pages de destination AdWords qui ne sont pas liées en interne n’apparaissent pas dans les résultats. En général, c’est fait pour qu’elles n’influent pas sur le suivi d’AdWords. Cela signifie que ces pages sont invisibles pour notre robot. Par contre, bien évidemment, Google voit bien ces pages.

Si vous saisissez un sitemap de votre projet avec Google, il sera peut-être avantageux de le lier à l’intérieur de robots.txt. De cette façon, notre robot peut le reconnaître et l’utiliser comme base d’exploration.

L’existence de contenus dupliqués peuvent également être l’une des raisons pour laquelle il peut y avoir une différence de valeurs entre les pages indexées par la recherche Google et le nombre de pages explorées dans votre projet.